Resumo

Desde 2014 o INEP erra no calculo de um dos indicadores de qualidade de cursos no ensino superior, o chamado IDD. Este indicador é o principal componente do CPC, a “Nota do MEC” de um curso em nível superior. Corrigindo o erro mudaria a classificação de muitos cursos. Por exemplo, 9 cursos de Medicina avaliados em 2019 que foram considerados “satisfatórios”, seriam avaliados como “não-satisfatório” se cálculo correto seria usado. Procurado, o INEP afirma que não irá recalcular o CPC usando a metodologia correta. Veja o preprint que descreva o resultado da pesquisa (submetido para publicação). (19/07/2021: este trabalho foi publicado em Avaliação: Revista da Avaliação da Educação Superior)

Abaixo resumo os resultados principais da pesquisa.

Introdução

O INEP é o órgão do governo federal responsável pela construção de avaliações, estatísticas e indicadores educacionais. Uma das suas responsabilidades é criar indicadores de qualidade de instituições e cursos de ensino superior. Estes indicadores, às vezes chamados de “Nota do MEC”, fazem parte de um sistema regulatório desenhado para assegurar a qualidade do ensino superior, uma tarefa dificultada pelo grande número e variedade de cursos e instituições atuando no Brasil.

Segundo o Censo da Educação Superior de 2019, existam atualmente no Brasil 2600 Instituições de Ensino Superior (IES), dos quais 300 são públicos. Estas Universidades, Faculdades e Centros Universitários oferecem um total de 40 mil cursos. Como os quase 9 milhões de estudantes (3,6 milhões de ingressantes) escolham sua universidade ou faculdade? Como podem avaliar a qualidade dos cursos? É o MEC que autoriza a abertura de novos IES e cursos e seu funcionamento continuado. O Brasil é um dos poucos países no mundo que neste sistema regulatório faz uso intenso de indicadores quantitativos, gerados a partir do dados do Censo (como o número de Doutores e Mestres no corpo docente e indicadores de infraestrutura) e o ENADE, o exame padronizado aplicado a estudantes concluindo seu curso. Há visitas in loco também (necessariamente para novos IES e cursos), mas o indicador quantitativo chamado CPC é o mais importante para o re-credenciamento de cursos existentes.

ENADE, valor agregado e o IDD

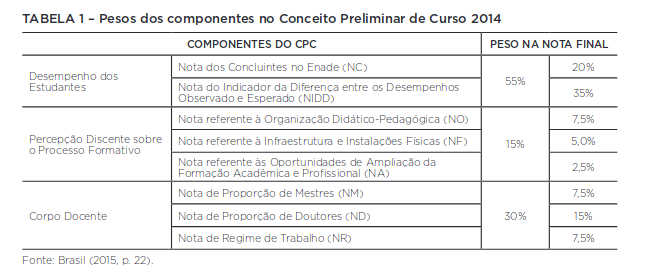

O CPC é um indicador composto com o objetivo de quantificar a “qualidade” de um curso no ensino superior. Veja seus componentes:

A maior parte do CPC deriva do ENADE e o chamado IDD, o indicador de valor agregado que entra com peso de 35%. Valor agregado neste contexto busca “controlar” o desempenho dos egressos de um curso no ENADE pela aptidão acadêmica dos seus ingressantes. Na prática é uma tentativa de dar o devido valor no CPC para cursos com baixa seletividade. Afinal, cursos com ingressantes com baixas notas no ENEM tendem a ter desempenho baixo no ENADE, mas alguns cursos agregam mais valor (no sentido de conseguir elevar a nota ENADE dos egressos) do que outros e devem ser reconhecidos por isso.

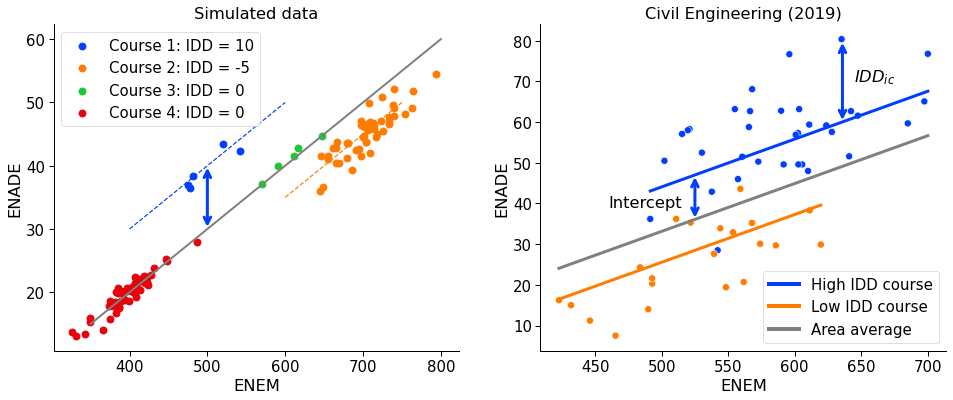

O modelo do INEP para “controlar” o desempenho dos egressos de um curso pela aptidão acadêmica dos seus ingressantes usa a nota do ENEM. Como esquematizado na figura abaixo, verifique-se que a nota na ENADE do ingressante é aproximadamente proporcional a sua nota no ENEM. Mas alguns cursos (o dos egressos azuis na figura) conseguem elevar a nota da ENADE mais que outros (o dos egressos laranjas), apesar de ter uma turma com notas no ENEM pior.

O erro do INEP

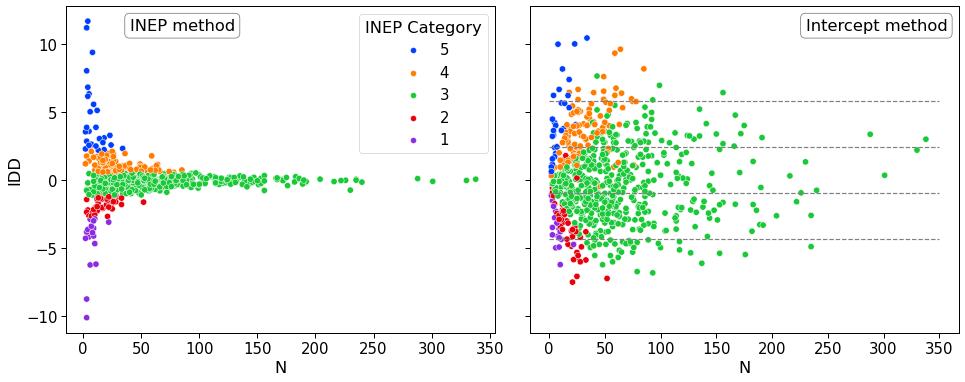

Acontece que desde 2014, quando o INEP mudou sua metodologia de cálculo do IDD, este indicador está sendo calculado errado. Um primeira indicação que algo está muito errado é que o indicador tem o comportamento de um gerador de números aleatórios. Na figura abaixo, mostro os IDD dos cursos de Engenharia Civil avaliados em 2019. Se o IDD é calculado segundo o método do INEP, somente cursos com um número da estudantes avaliados abaixo de 50 tem valores altos ou baixos. Todos os cursos com número alto de participantes no ENADE são avaliados como medianos. Este é uma primeira indicação que o IDD como calculado pelo INEP em grande parte é aleatório, sem relação com a qualidade do curso.

Ao investigar, descobri que a razão deste comportamento é que o INEP faz um erro simples: ao invés de usar o intercepto para estimar o valor agregado usando o modelo estatístico visualizado no gráfico acima, usam a média do resíduos (IDDic, na figura acima). Isso é um erro que faz, nas palavras do ex-presidente do INEP Reynaldo Fernandes, o indicador ser “por construção um ruído aleatório”.

Se usar o método correto, há menos o comportamento típico de um “gerador de números aleatórios”.

Consequências

Para fins regulatórios o INEP transforma o CPC em 5 categorias. Sem muitas justificativas, alias, é dada a interpretação que as categorias 1 e 2 são “insatisfatórias” e 3-5 “satisfatórios”. Há um estudo interessante a se fazer sobre a (falta de) validação destes conceitos e a maneira que são calculados, mas a realidade administrativa atual é que cursos avaliados com conceito CPC 1 ou 2 podem receber uma visita in loco e são colocados em observação.

O IDD tem um peso de 35% no CPC e o erro do cálculo do INEP faz por exemplo 9 dos 215 cursos avaliados na área de Medicina “cair” de um conceito satisfatório para insatisfatório (veja quais são abaixo).

| Curso | Sigla IES | Org Acad | Cat Acad | CPC (INEP) | CPC (faixa) | CPC (corrigido) | CPC (faixa corrigido) |

|---|---|---|---|---|---|---|---|

| 18594 | UNESA | Universidade | Privada com fins lucrativos | 2.261 | 3 | 1.622 | 2 |

| 7414 | UNIG | Universidade | Privada sem fins lucrativos | 2.404 | 3 | 1.869 | 2 |

| 18605 | UNIGRANRIO | Universidade | Privada com fins lucrativos | 2.079 | 3 | 1.682 | 2 |

| 10289 | FMC | Faculdade | Privada sem fins lucrativos | 2.348 | 3 | 1.851 | 2 |

| 15343 | UNITAU | Universidade | Pública Municipal | 2.176 | 3 | 1.723 | 2 |

| 49060 | UNINILTONLINS | Universidade | Privada sem fins lucrativos | 2.093 | 3 | 1.811 | 2 |

| 19206 | UNIMES | Universidade | Privada sem fins lucrativos | 2.342 | 3 | 1.745 | 2 |

| 69464 | UNIPLAC | Universidade | Privada sem fins lucrativos | 2.046 | 3 | 1.774 | 2 |

| 60660 | UEA | Universidade | Pública Estadual | 1.953 | 3 | 1.615 | 2 |

Reação do INEP

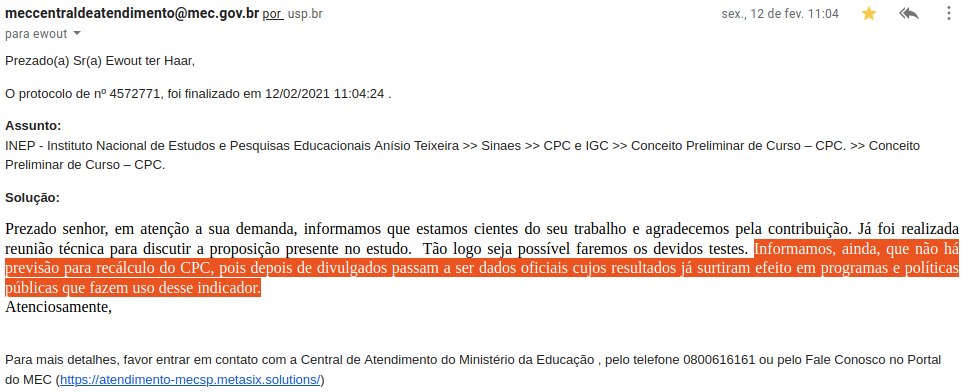

Mostrei o preprint a dois ex-diretores do INEP, o Prof. Otaviano Helene e Prof. Reynaldo Fernandes (ambos meus colegas na USP). Deram feedback positivos que incorporei no texto e me disseram que foram convencidos do argumento principal do texto.

Procurado, os representantes do INEP disseram que não tem previsão de re-calcular o CPC para os anos 2014-2019. É interessante contemplar que segundo o INEP gerar um número para fins regulatórios é considerado finalidade em si mesmo, não sendo passível de correções.

Conclusão

O titulo do preprint é “A correct method to calculate the IDD value added indicator in the Brazillian higher education quality assurance framework”. Mas não estou afirmando que o método corrigido é necessariamente a melhor forma de criar um indicador para valor agregado. Na verdade, sou bastante cético em relação a possibilidade de criar indicadores “objetivos” ou quantitativos confiáveis e válidos a partir dos dados do ENADE. Não é a toa que o Brasil é o único país no mundo que organiza seu sistema de avaliação do ensino superior desta forma. É muito difícil criar um exame padronizado para egressos superior, sobretudo porque em comparação com etapas escolares anteriores a variedade de objetivos é muito grande.

Acredito também que este episódio mostra como falta no INEP uma cultura de validação das métricas que geram. É desmoralizante saber que um indicador de qualidade é calculado com um erro grosseiro por seis anos sem que algum ator interessado, como gestores de cursos universitários ou gestores do MEC, levantar algum tipo de dúvida. Na minha opinião, isso parece mostrar que os números do MEC, pelo menos neste caso, servem mais para gerar um espécie de objetividade raso e performático, sem que há interesse saber se há uma realidade por trás destes números.